총 113 건

-

JAI - 싱글 라인 스캔 카메라를 통한 가시광선과 SWIR 동시 이미징

JAI - 싱글 라인 스캔 카메라를 통한 가시광선과 SWIR 동시 이미징싱글 라인 스캔 카메라를 통한 가시광선과 SWIR 동시 이미징 디지털카메라 및 이미지 센서 기술의 지속적인 개발과 빠른 데이터 전송 인터페이스 및 첨단 컴퓨터 이미지 처리 알고리즘 덕분에 자동 비전 검사 시스템은 계속해서 더욱 정교하고 효율적으로 성장하고 있습니다. 제조 회사는 이러한 기술 개선을 기반으로 생산 프로세스를 가속하여 제조 효율성과 생산 수율을 향상할 수 있었습니다. 또한 카메라 기술의 발전으로 인해 제조 라인 전체에서 더 뛰어난 품질 검사 루틴이 가능해져 완제품을 더 높은 품질로 생산할 수 있게 되었습니다. 머신 비전 시스템에서 가장 많이 활용되는 이미징 기술은 약 400nm~700nm의 전자기 범위에서 가시광선을 감지하는 컬러 및 흑백 CMOS 센서가 탑재된 산업용 카메라입니다. 그러나 최근 몇 년 동안 머신 비전 업계에서는 약 1050nm~2500nm 사이의 단파 적외선(SWIR)을 감지할 수 있는 InGaAs(인듐/갈륨/비소) 센서 기술이 탑재된 카메라와 같이 가시광선 스펙트럼 외의 광자를 감지할 수 있는 산업용 카메라에 대한 관심이 높아지고 있습니다. SWIR은 재료와 상호 작용할 때 가시광선과는 다른 물리적 현상을 보입니다. SWIR은 재료의 분자와 상호 작용할 때 광자가 흡수되는 유기 및 비유기 재료로 더 깊이 투과할 수 있습니다. 흡수 수준은 재료의 화학 구조에 따라 달라집니다. 예를 들어 물 분자는 1,450-1,500nm 파장에서 높은 SWIR 흡수 수준을 가집니다. 따라서 SWIR 이미징은 과일 및 채소 검사와 같은 애플리케이션에 유용합니다. 조기 부패 및 멍이 있는 경우(일반적으로 수분 함량이 높은 부분) 카메라 이미지에서 높은 대비를 보이므로 SWIR 스펙트럼에서 더 명확하게 나타납니다. 이를 통해 이러한 결함이 있는 품목을 더욱 쉽게 식별하여 포장 전에 컨베이어 벨트에서 제거할 수 있습니다. SWIR 이미징을 유용하게 활용할 수 있는 또 다른 애플리케이션은 이물질을 감지하는 것입니다. 예를 들어, 식품 가공의 경우 돌, 금속 및 플라스틱과 같은 항목을 감지하여 효율적으로 제거해야 합니다. 농산물 일괄 검사의 경우 가시광선의 컬러 이미지로는 이물질을 식별하기 어려울 수 있지만 SWIR 이미지에서는 이물질이 식품보다 어둡게 보이기 때문에 소프트웨어 알고리즘 및 컨베이어 벨트의 분리 메커니즘을 통해 이물질을 제거할 수 있습니다. SWIR은 불투명한 플라스틱과 유리를 "투과"할 수 있어 포장 및 용기의 오염을 확인하고 내용물의 정확한 양이나 액체 또는 분말의 채움 레벨을 확인하는 데에도 사용할 수 있습니다. 새로운 R-G-B-SWIR 라인 스캔 카메라(SW-4010Q-MCL)를 사용하면 식품 용기 외부의 품질과 완성도를 검사하는 동시에 내부의 내용물을 확인할 수 있습니다. 반도체 품질 검사 스테이션의 경우, SWIR을 통해 실리콘을 "투시"하여 실리콘 웨이퍼의 표면과 표면 아래의 결함을 찾을 수 있습니다. 직물 및 목재 검사와 같은 애플리케이션의 경우, SWIR 이미징을 사용하여 염색된 직물이 다음 작업을 위해 충분히 건조되었는지 확인하거나 절단된 목재에 숨겨진 결함이 있는지 확인할 수 있습니다. 기타 애플리케이션으로는 플라스틱 폐기물 분류, 광물 분류, 배터리 검사, 농업/임업 애플리케이션 등이 있습니다. SWIR 카메라는 검사 프로세스의 효율성을 높일 수 있지만, 많은 머신 비전 애플리케이션에는 크기와 모양을 확인하고 개체의 색상 뉘앙스를 분석하고 라벨 또는 기타 인쇄물의 색상을 확인하기 위해 일반 가시광선을 활용하는 카메라가 여전히 필요합니다. 따라서 SWIR 이미징은 가시광선을 활용하는 일반적인 검사 루틴을 보완하는 기술이라고 할 수 있습니다. 많은 애플리케이션의 경우 품질 검사 요건을 충족하기 위해서는 동일 제조 라인에서 가시광선 및 비가시광선 이미징 기술을 함께 활용할 수 있어야 합니다. 기존에는 가시광선과 SWIR 또는 NIR을 활용하는 검사 스테이션에서 별도의 카메라, 조명, 렌즈 및 마운트를 사용하여 제조 라인을 따라 별도의 검사 단계를 진행해야 했기 때문에 셋업이 복잡하고 많은 비용이 들었습니다. 산업용 카메라 제조업체 JAI는 이 문제를 해결하기 위해 1대의 카메라로 가시광선과 SWIR 이미지를 동시에 촬영할 수 있는 새로운 멀티 센서 카메라 기술을 출시했습니다. JAI Sweep+ 시리즈의 최신 제품은 4,096 픽셀 해상도를 지원하는 CMOS 라인 센서 3개와 라인당 1,024 픽셀 해상도를 지원하는 추가 InGaAs 센서가 통합된 컬러 라인 스캔 카메라입니다. JAI의 새로운 멀티 센서 라인 스캔 카메라는 3개의 개별 CMOS 센서를 통해 적색, 녹색, 청색 가시광선을 동시에 캡처하고 InGaAs 기술을 기반으로 하는 4번째 센서를 통해 SWIR을 캡처합니다. 이 카메라는 첨단 카메라 내장 프리즘 기술과 이색(dichroic) 필터를 통해 입사광을 4개의 채널로 분할하여 3개의 CMOS 센서에서 적색, 녹색, 청색 가시광선을 동시에 캡처하고 InGaAs 센서를 통해 SWIR을 캡처합니다. 1개의 검사 스테이션으로 매우 미묘한 색상 차이를 확인하기 위한 이미지 데이터를 제공하는 동시에 SWIR 이미징 데이터를 통해 더욱 수월하게 숨겨진 결함이나 원치 않는 개체를 찾을 수 있습니다. 차트는 3개의 CMOS 센서(청색, 녹색, 적색)와 SWIR을 캡처하는 InGaAs 센서의 스펙트럼 응답을 보여줍니다. SWIR(노란색) 라인의 높이는 RGB 라인과 연관이 없습니다. 새로운 라인 스캔 카메라에는 RGB 출력을 HSI, CIE XYZ, sRGB, Adobe RGB와 같은 특정 색 공간으로 변환할 수 있는 내장 색 공간 변환과 같은 다양한 첨단 기능이 포함되어 있습니다. 이미지 밝기와 색상 밸런스를 개선하기 위해 R-G-B 및 SWIR 채널에 대한 노출 시간을 개별적으로 설정하여 파장대별로 광 축적 시간을 늘릴 수 있습니다. 또한 4개 채널에서 아날로그 및 디지털 이득을 각각 설정할 수 있습니다. 4096 픽셀 해상도로 설정된 경우 R-G-B 채널의 최대 라인 속도는 20kHz이며 SWIR 채널의 경우 1024 픽셀 해상도에서 39kHz입니다. R-G-B 채널의 기본 픽셀 크기는 7.5 x 7.5 µm, SWIR 채널의 기본 픽셀 크기는 25 x 25 µm입니다. 이 카메라에는 R-G-B 및 SWIR 센서의 FOV(Field-of-View)와 라인 속도를 동기화하기 위한 Xscale이라는 특수 픽셀 크기 조정 기능이 탑재되어 있습니다. 관심 영역(ROI) 설정과 Xscale 기능을 사용하여 RGB 센서의 픽셀 크기를 조정하면, RGB 센서의 센서 폭이 30.72mm에서 SWIR 센서와 동일한 25.6mm로 변경됩니다. 동시에 R-G-B 스캔 속도는 20kHz에서 SWIR 스캔 속도와 동일한 39kHz로 증가하게 됩니다.

2023.03.14 -

Photoneo - 수요가 증가하는 산업에서 로봇은 어떻게 도움이 될까요?

Photoneo - 수요가 증가하는 산업에서 로봇은 어떻게 도움이 될까요?수요가 증가하는 산업에서 로봇은 어떻게 도움이 될까요? [로봇이 증가하는 산업수요에 맞춰 할 수 있는 일] 기술과 IT의 급속한 발전은 다양한 산업에서 무한한 가능성과 기회를 가져다 주었습니다. 특히 로봇은 많은 장점 덕분에 큰 산업과 틈새시장 등 모든 규모의 산업에서 활용되고 있습니다. 수요가 증가된 산업에서 로봇이 도움이 되는 7가지 이유는 다음과 같습니다. #1 비용 절감 무엇보다 로봇은 운영 비용과 자본 비용 모두를 줄이는 데 도움이 됩니다. 로봇 자동화는 근로자가 직접 작업하는 것 보다 훨씬 낮은 비용이 듭니다. 이렇게 로봇은 기업의 직,간접 비용을 줄일 수 있게 해주어 시장에서 더 많은 경쟁력을 얻게 합니다. 예를 들어, 로봇을 사용하면 조명이나 난방의 에너지 비용을 줄이는데 도움이 됩니다. 특히 특정한 작업을 자동화하면, 직원들이 창의성을 발휘하거나 의사결정 능력이 필요한 더 중요한 작업에 집중할 수 있습니다. 또한 로봇 자동화는 생산성과 효율성 보장을 통해서도 비용절감을 가져옵니다. Photoneo의 3D비젼과 로봇 인공지능을 이용하면 사람이 직접 하는 것 보다 더 우수한 정밀도와 신뢰성으로 광범위한 작업에서 세밀한 물체 제어가 가능합니다. MotionCam-3D Color – 이동하는 물체를 실시간으로 모델링 하여 높은 품질의 컬러 3D 데이터를 얻을 수 있는 새롭고 획기적인 장치 예로, Photoneo의 3D 카메라 MotionCam-3D는 *motion artifact없이 빠른 속도로 움직이는 물체의 고품질 3D 스캐닝이 가능합니다. * 움직이는 물체를 촬영할 때 발생하는 이미지 상의 인공물. 실제로는 존재하지 않음 새롭게 출시된 Color 버전 MotionCam-3D를 통해 이제는 움직이는 물체의 풍부한 색상 3D 데이터도 실시간으로 얻을 수 있습니다. 이 새롭고 획기적인 기능은 depth 데이터 뿐만 아니라 색상에 의존해야 하는 AI 애플리케이션에서 장점을 발휘합니다. #2 품질향상 로봇을 사용하면 품질향상의 이점을 얻을 수 있습니다. 생산과정에서 신뢰성과 정밀도를 크게 높여주기 때문입니다. 자동화는 지루하고 반복적인 활동으로 인해 발생할 수 있는 작업자의 피로와 주의 산만과 같은 위험요소를 제거해줍니다. 사람과 달리 로봇은 피곤하거나 휴식을 필요로 하지 않아 24시간, 언제나 일할 수 있기 때문이죠. MotionCam-3D를 이용한 움직이는 큰 물체의 검사 최첨단 3D 비전을 탑재한 로봇은 검사와 품질관리에서 신뢰성과 정밀도를 크게 높일 수 있습니다. 3D 데이터 기반의 검사시스템으로 제품의 이상 유무를 판단하고 그에 따라 분류할 수 있기 때문입니다. #3 원자재 절약 로봇 자동화는 더 높은 제품 품질과 더 나은 작업 정확도를 통해 자원 낭비를 줄여 생산량을 증가 시킵니다. 제조 효율을 극대화함으로써 기업은 생산에 필요한 에너지와 자원을 최소화 할 수 있습니다. #4 안정성 증대 기업은 직원들의 건강과 안전을 가장 중요하게 생각합니다. 이것이 바로 위험한 일을 하는 경우에도 직원들을 안전하게 지킬 수 있는 방법을 찾는 이유입니다. 운 좋게도, 로봇은 이 문제를 해결할 수 있습니다. 로봇을 이용한 무겁고 큰 가스 실린더 작업 by Tecnalia 로봇은 노동자가 위험할 수 있거나 많은 체력이 필요한 작업을 대신하는데 사용됩니다. 또한 안전해 보이는 단순 작업이지만 무리한 반복으로 입을 수 있는 부상 위험을 줄일 수 있습니다. #5 우수한 품질 로봇을 사용하여 얻는 효율성을 고려할 때, 장기적으로 회사의 생산성을 높이는 데 로봇이 도움된다는 것은 놀라운 일이 아닙니다. 로봇 자동화는 생산성과 효율성을 향상시켜 짧은 시간 내에 더 많은 제품을 생산할 수 있도록 합니다. 생산성 향상을 통해 생산 규모를 확장할 수 있는 기회가 생길 수 있습니다. 게다가, 작업량이 감소하고 재고 회전율이 증가하는 것을 확인할 수 있습니다. 가장 큰 장점 중 하나는 야간과 주말에 스스로 혹은 적은 관리인원만 두고도 생산할 수 있다는 것입니다. 이를 통해 마감일을 준수할 수 있고 직원들에게 스트레스를 주지 않으면서 전체 생산량을 훨씬 더 증가시킬 수 있습니다. 로봇은 병가와 휴식이 필요하지 않습니다. 예를 들어, Bin Picking Studio와 같은 로봇 지능 도구는 여러분 회사에 소중한 새식구가 될 것입니다. #6 이직률 감소 기업들이 직면한 주요 과제는 다양한 이유로 발생하는 높은 이직률입니다. 과로에 빠져 근무 환경에 만족하지 못하는 경우, 회사 경영에 만족하지 않을 경우 등 이직의 이유는 다양합니다. 전자상거래에서 로봇을 이용한 선반에서 상품작업 다행히도, 로봇은 이직률을 낮추고 채용의 어려움을 줄이는 데 도움을 줄 수 있습니다. 고도로 숙련된 직원은 찾기 어려울 수 있지만 로봇은 모든 유형의 복잡하고 까다로운 작업에도 효율적으로 사용될 수 있기 때문이죠. #7 다양성 향상 앞서 설명한 이유와 같이 로봇을 이용한 자동화 솔루션은 제품 생산에 있어 유연성을 높이는데 큰 도움이 됩니다. 특히 AI와 고성능 3D 비전을 기반으로 한 솔루션은 매우 인기가 많습니다. 예를 들어, 피킹로봇은 한 종류의 물체를 집기위한 단일 목적으로 구성되지 않고 소프트웨어 추가를 통해 새로운 모양의 물체도 집을 수 있게 수정될 수 있습니다. 이렇게 유연한 자동화를 통해 기업은 적은 노력과 투자로 다양한 다른 제품 생산으로 전환할 수 있습니다. 로봇을 이용한 택배상자 선택 및 분류작업 from Dedoles 마무리하며.. 로봇은 증가하는 수요를 충족시킬 뿐만 아니라 확장을 원하는 모든 기업에게 매우 귀중한 자산이 될 수 있습니다. 이 기사에 나열된 로봇 자동화의 장점을 고려하여 귀사 프로젝트에서 적용할 수 있는 최고의 솔루션을 저희 (주)화인스텍에 문의해주세요. 원문: How can robots help businesses meet increased demand? - Photoneo Focused on 3D By Lillie Jenkins

2023.02.22 -

Tichawa 센서 vs. 일반 CIS

Tichawa 센서 vs. 일반 CISTichawa 센서 vs. 일반 CIS Tichawa CIS 기술과 일반적인 CIS 기술은 어떻게 다를까요? Tichawa 센서에는 새로운 기능들이 많이 추가되었습니다. 더욱 긴 Working Distance, 굴곡진 제품에 대한 검사 기능, Gapless 센서 기술, 진공 기능 그리고 Shape for Shape 기능 등이 그것들입니다. Gapless inspection: 긴 센서 라인(최대 4m)은 생산 중에 많은 센서 칩을 정렬해야 합니다. 칩들이 바로 옆에 정렬되면 칩 경계에 틈이 생기고 픽셀이 누락되는 형태로 카메라 이미지에도 영향을 미칩니다. 당사의 센서 칩은 센서 칩 사이에 기계적인 간극이 발생하지 않도록 배열되어 있습니다. 이렇게 하면 간격이 없는 이미지를 얻을 수 있습니다. 최대 16mm 높이의 물체에 대한 3D 검사 가능: 기존 CIS 기술은 짧은 Working distance에서 얕은 심도 (Depth of Field)를 제공합니다. TICHAWA는 VDCIS 기술을 통해 최대 60mm의 Working Distance에서 16mm의 심도 (DOF)를 제공합니다. Inspection in a vacuum: 기존 CIS 센서 뿐만 아니라 일반적인 산업용 카메라들은 진공상태에서 케이스가 찢어지기 때문에 사용이 불가능 합니다. TICHAWA Vision의 제품은 3bar의 압력을 견딜 수 있도록 디자인되어 있기 때문에 진공 상황에서도 사용이 가능 합니다. Shape from Shading: 지금까지 3D 구조 검사의 경우 매우 복잡한 조명과 카메라 시스템으로만 가능 했습니다. “Shape from Shading”이라는 이름으로 1970년대부터 알려진 기술은 4개의 조명과 하나 이상의 카메라를 통해 3D 검사를 수행합니다. TICHAWA VISION은 이 기술을 제품에 접목시켜 CIS센서에서 컴팩트하게 Shape from Shading 기능을 구현하였습니다. 생산 공정에서의 굴곡진 제품에 대한 검사: Tichawa Vision은 CIS센서를 개선하여 파이프, 튜브, 캔, 끝없는 와이어 및 로프와 같은 원형 물체를 스캔하는 데에도 사용할 수 있습니다. 이러한 검사를 위하여 CIS센서를 링 형태로 구부려 제작하였으며 제품이 이 링모양의 센서를 지나가게 하여 검사를 가능하게 하였습니다. (RingCIS) 100% Inside Inspection: 튜브 내부를 왜곡 없이 검사하기 위한 솔루션은 지금까지 시장에 없었습니다. Tichawa Vision은 이를 가능하게 하는 두 가지 제품인 BoroCIS와 TubeCIS를 개발했습니다. 100,000 pixels/line: Tichawa 제품은 라인당 100,000 픽셀 이상을 처리할 수 있어 넓은 스캔 폭에서도 높은 해상도를 얻을 수 있습니다.

2023.02.20 -

Photoneo - 픽 앤 플레이스(Pick & Place) 공정

Photoneo - 픽 앤 플레이스(Pick & Place) 공정픽 앤 플레이스 (Pick & Place) 공정에서 로봇은 어떻게 동작 하는가 최근에는 대부분의 생산 현장에서 많은 종류의 로봇을 볼 수 있습니다. 이러한 로봇들은 수없이 많은 비즈니스에서 생산 공정 전체를 아울러 적용되어지고 있습니다. 픽 앤 플레이스(Pick & Place)는 이러한 로봇 사용 사례 중 하나 입니다. 이 작업은 특정 영역에 있는 물체를 사용자가 정의 해 놓은 다른 장소로 이동 시키는 것 입니다. 이 작업을 통해 제품의 생산 공정 속도를 굉장히 빠르게 만들 수 있습니다. 이 블로그 글에서는 Pick & Place에서 로봇이 어떤 역할을 하는지 알아보겠습니다. Pick & Place 로봇이란 무엇인가? Pick & Place 로봇은 물류창고와 생산 공장에서 가장 많이 볼 수 있는 산업용 로봇입니다. 이 로봇은 아래의 작업을 통해 공정을 돕습니다. * 박스로부터 제품을 꺼내기 * 제품을 박스에 넣기 * 제품을 특정 위치에서 다른 위치로 혹은 지정된 저장 공간으로 이동시키기 로봇 팔(Arm)의 끝단에는 사람의 손과 같이 여러가지 종류의 물체를 집을 수 있는 End effector 가 장착됩니다. 이 End effector에는 제품의 생산 공정을 위해 추가적인 부품이 장착될 수 있습니다. Pick & Place 로봇은 무엇을 하는가? 조금 더 자세하게 설명하자면, Pick & Place 로봇은 대체로 하기의 작업을 수행합니다. * 박스나 컨베이어 벨트로 이동 시켜야 하는 각기 다른 사이즈와 모양의 제품을 집어 냅니다. (Picking) * 무작위로 쌓여 있는 제품을 창고 내의 다른 장소로 이동 시킵니다 * 조립 – 작은 제품을 플랫폼 위로 이동 시켜 함께 다음 공정으로 이동할 수 있도록 합니다. * 그 밖에 많은 어플리케이션 Picking 절차 (Photo courtesy of PWR Pack) Pick & place 로봇은 굉장히 넓은 영역에 사용될 수 있습니다. 어플리케이션의 요청 사항에 따라 여러가지 종류의 End effector를 장착할 수 있습니다. 가장 보편적인 것으로는 석션 컵이 있는 흡착식 그리퍼 (vacuum gripper), 핑거 그리퍼 (finger gripper), 발톱형 그리퍼(clawed gripper), 마그네틱 그리퍼(magnetic gripper) 그리고 커스텀 그리퍼(custom gripper)가 있습니다. 경우에 따라 유연성이 높은 레벨의 시스템을 만들기 위해 여러 개의 로봇 팔(arm)과 헤드(end effector)를 사용하기도 하며 이를 통해 시간 지연 없이 여러 각도에서 물체로 접근할 수 있게 합니다. Pick & Place 로봇은 제조 라인에서의 모든 생산 공정을 획기적으로 개선 시킬 수 있습니다. 이를 통해 생산 시간을 빠르게 할 수 있으며 또한 생산에 필요한 공간도 절약할 수 있습니다. 예를 들어, 컨베이를 사용하는 시스템의 경우 특별한 목적을 위해 다른 종류의 제품이 이동하게 됩니다. Pick & Place 로봇은 특정 부품을 집어 낼 수 있도록 프로그램 할 수 있습니다. 즉, 특정 모양 혹은 색상의 제품을 집어서 사용자가 원하는 위치로 빠르게 이동 시킬 수 있는 것입니다. 제조공정에서의 Pick & Place 로봇 여러 개의 로봇 팔(arm)에 suction cup 혹은 vacuum 방식의 그리퍼를 사용하는 경우 Picke & place 로봇은 조립 공정을 비롯한 넓은 영역의 제조 공정을 자동화 할 수 있도록 해 줍니다. 여러 개의 로봇 팔을 이용하여 한 번에 여러 개의 물체를 집을 수 있으며 크기가 작은 물체부터 큰 물체까지 모두 커버 할 수 있습니다. 즉, 생산라인에서 여러가지 다양한 물체에 대해서 생산을 자동화하기에 적합하다는 것입니다. 예를 들어, 첨단 기업들은 때때로 다른 사이즈와 다른 모양의 부품들을 함께 생산하곤 합니다. 비슷한 예로 자동차 생산 업체들은 크기 가 큰 SUV와 소형차를 함께 생산합니다. Pick & place 로봇은 수많은 종류의 제품을 빠르고 효율적으로 다룰 수 있도록 해줍니다. 머신비전을 장착한 Pick & place 로봇 (Photo courtesy of PWR Pack) 앞서 얘기한 모든 작업을 수행하기 위해서 로봇은 볼 수 있어야 합니다. 3D 비전은 정확한 식별과 안정적인 제품의 Picking을 위해서 꼭 필요합니다. (이러한 비전 솔루션이 없다면 로봇은 장님이나 다름없습니다) 현재 시장에는 다양한 3D 비전 기술이 있습니다. 포토네오 (Photoneo)의 3D 스캐너와 3D 카메라는 다양하고 혹독한 산업 환경에서도 안정적으로 작업을 수행할 수 있습니다. 포토네오의 PhoXi3D 스캐너는 정지된 상태의 물체에 대한 높은 해상도와 높은 정밀도의 3D 이미지를 제공합니다. MotionCam3D의 경우 빠르게 움직이는 물체에 대해서도 3D 스캔이 가능 합니다. 사용자께서는 어플리케이션에 적합한 3D 솔루션을 제안 받고 싶으시거나 상담 혹은 테스트가 필요 하실 때 ㈜화인스텍으로 연락 주시면 성심껏 지원 드리도록 하겠습니다. 출저: By Andrew Lightstead https://www.photoneo.com/how-pick-and-place-robots-work

2023.02.16 -

Euresys eGrabber 소개

Euresys eGrabber 소개blog.naver.com eGrabber Euresys에서 제공하는 이미지 취득 및 녹화 라이브러리를 통칭합니다. 특징 - 이미지 취득 및 녹화용 툴 세트 - CoaXPress 카메라 호환 (Coaxlink 보드 사용시) - Camera Link 카메라 호환 (Grablink DUO 보드 사용시) - GigE Vision 카메라와 호환 (eGrabber Gigelink 라이브러리 사용시) - 하드 드라이브에 녹화 가능 (eGrabber Recorder 라이브러리 사용시) eGrabber는 CoaXPress, Camera Link 및 GigE Vision 카메라를 사용하여 비전 어플리케이션의 개발 및 디버깅을 가능하게 하는 통합 소프트웨어 드라이버, 툴 및 어플리케이션 세트입니다. eGrabber에는 Euresys의 Coaxlink 및 Grablink DUO 프레임 그래버 드라이버, GigE Vision 이미지 취득 라이브러리, 고성능 비디오 녹화 라이브러리, 그리고 사용자 친화적인 평가 및 데모 어플리케이션이 포함되어 있습니다. eGrabber는 여러 프로그래밍 언어와 호환되며, GenICam을 기반으로 하며 GenAPI와도 호환되며 GenTL 인터페이스를 제공합니다. eGrabber는 EGrabberBridge 클래스로 인해 eGrabber 내에서 취득한 이미지를 Open eVision 이미지 처리 라이브러리에서 원활하게 처리할 수 있습니다. Open eVision은 텍스트 및 코드 판독, 일치 및 측정, 3D 처리 및 딥 러닝 검사를 위해 이미지를 처리할 수 있는 이미지 분석 라이브러리 및 소프트웨어 도구 세트입니다. eGrabber Bridge를 통해 카메라와 원활하게 인터페이스(핸드셰이크 및 데이터 형식)할 수 있으므로 이러한 라이브러리에 액세스할 수 있습니다. https://blog.naver.com/fainstec_sales/222899361070 EURESYS_Library Open eVision 3D 소개 1. 소개 Easy3D : Depth Map, Point Cloud, ZMap 그리고 뷰어 사용을 위한 기초 라이브러리 Easy3... blog.naver.com https://blog.naver.com/fainstec_sales/222902350817 EURESYS_Library Open eVision 2D 소개 1. 주요기능 Open eVision 은 이미지 처리와 분석을 위한 Software Tool 사용자의 Application 에 통... blog.naver.com eGrabber Driver - CXP, GigE, Camera Link 사용 드라이버 통합 SDK로 인터페이스 상관 없이 제어 가능 특징 실시간 이벤트 처리를 위한 싱글 스레드 및 멀티 스레드 콜백 지원 프레임 그래버 및 카메라 구성을 위한 스크립트 파일 지원 GenICam, GenAPI, GenTL 호환 Windows, Linux 및 MacOS 호환 eGabber Driver는 Coaxlink 및 Grablink DUO 프레임그래버에서 이미지를 취득하기 위해 사용하기 쉬운 프로그래밍 인터페이스를 제공하는 클래스 라이브러리입니다. eGrabber는 C++, C# 및 Python과 호환되는 사용자 친화적인 고급 객체 지향 API를 제공합니다. Euresys::EGrabber는 C++ 클래스 라이브러리입니다. 또한 .NET 어셈블리를 통해 .NET 언어(C#, VB.NET등)에 사용할 수 있습니다. Python 바인딩은 Python 휠 설치 패키지로도 제공됩니다. (현재 모든 API는 x64만 지원합니다) eGrabber Studio - 이미지 캡처 도구 Euresys에서 제공하는 이미지 취득, 녹화 등을 한 툴에서 통합하여 사용 가능 특징 eGrabber에서 제공하는 인터페이스의 통합 이미지 취득 소프트웨어 CoaXPress, Camera Link, GigE 등 다양한 인터페이스 지원 Recorder 기능 사용 가능 라이브 히스토그램 및 프로파일 사용 가능 소지하는 라이센서 및 보드에 따라 사용 가능한 기능이 다름 eGrabber Studio는 eGrabber의 평가 및 데모 어플리케이션입니다. Coaxlink 프레임 그래버 및 GigE Vision 카메라를 사용하여 이미지 캡처를 테스트하고 카메라 및 프레임 그래버의 파라미터(GenApi 기능)를 확인 및 구성하고 캡처한 이미지를 파일로 저장할 수 있습니다. 라이브 히스토그램 및 프로파일 표시도 가능합니다. 새롭고 현대적인 기능으로 설계된 eGrabber Studio는 Windows, Linux 및 macOS와 호환됩니다. https://blog.naver.com/fainstec_sales/222898465604 eGrabber Gigelink - GigE Vision을 사용하기 위한 라이브러리 통합 SDK로 카메라 제조사 상관 없이 제어 가능 특징 eGrabber Studio에서 사용 가능 카메라 제조사 상관없이 eGrabber SDK를 통해 카메라 제어 가능 Gigelink 라이센스 구매시 사용 가능(Neo License) Gigelink Neo License Gigelink는 GigE Vision 카메라에 대한 하드웨어 독립적인 범용 액세스를 제공하는 eGrabber의 선택적 라이브러리입니다. Gigelink를 이용하면 프로그래머가 CoaXPress 카메라(Coaxlink 보드 사용시) 및 카메라 링크 카메라(Grablink Duo 보드 사용시)를 사용할 때와 동일한 방식으로 eGrabber 컨셉, 객체 및 함수 호출을 사용하여 GigE Vision 카메라로부터 이미지를 취득할 수 있습니다, Gigelink는 GenICam 및 eGrabber Studio 어플리케이션과 호환됩니다. https://blog.naver.com/fainstec_sales/222899066610 EURESYS_Neo License 활성화 하는 방법 Neo License 활성화 시작메뉴 -> Euresys Neo License Manager 를 실행합니다. 2. PC에 Neo U... eGrabber Recorder - 고성능 이미지 녹화 라이브러리 제조사 상관 없이 동일한 규격으로 녹화 가능 특징 eGrabber Studio에서 사용 가능 eGrabber에서 제어 가능한 카메라 영상 녹화 가능 독점적인 확장자로 저장되며, TIFF 또는 MKV 파일로 변환 가능 Recorder 라이센스 구매시 사용 가능(Neo License) ? Recorder는 하드 드라이브에 최적화된 비디오 녹화를 제공하는 eGrabber의 선택적 라이브러리입니다. 이 라이브러리는 성능에 중점을 두어 디스크의 최대 대역폭을 이용하도록 고도로 최적화 되었습니다. 물론 실제 녹화 처리량은 디스크 용량에 따라 다릅니다. 그리고 하드 디스크 드라이브(HDD)뿐만 아니라 솔리드 스테이트 드라이브(SSD)와도 호환됩니다. eGrabber Memento - 이벤트 로깅 도구 디바이스, SDK 동작에 관련된 이벤트를 정확히 로깅하고 분석에 용이 특징 카메라, 프레임 그래버 동작에 관련된 이벤트에 대한 정확한 로깅 CPU 사용량이 매우 적음 eGrabber SDK와 별개로 별도 설치 필요 라이센스 구매 불필요 영상을 사용하는 고급 검사기에서 프레임 그래버, 카메라는 말할 것도 없고 모션이나 조명 제어기와 같은 수많은 외부 장치와 동기화하여 이미지를 캡처하는 역할을 합니다. 이러한 시스템을 디버깅하려면 일반적으로 예를 들어 오실로스코프나 논리 분석기와 같은 소프트웨어 프로파일러와 함께 사용되는 복잡한 장비가 필요합니다. 초당 수백 또는 수천 프레임이 넘는 매우 빠른 프레임 속도를 지원하는 최신 카메라가 나오면서 이 문제가 더욱 심각해지고 있습니다. Memento는 그러한 프로세스를 간소화할 수 있도록 설계되었습니다. 작업 중에 Memento는 호스트 어플리케이션뿐만 아니라 카메라, 프레임 그래버 및 그 드라이버에 관련된 이벤트 로그를 매우 상세하게 기록합니다. Memento는 백그라운드에서 실행되면서 시스템에 장애가 발생할 때 지원 팀에 보낼 수 있는 로그를 작성합니다. Memento는 보드의 드라이버 내부에 구현된 소프트웨어 리소스와 더불어 보드 자체의 하드웨어 리소스를 활용합니다. 그리고 Memento는 최고의 효율성을 제공하도록 설계되었습니다. 또한, 요구되는 CPU 사용량이 극히 낮으므로 비간섭적입니다. 강력한 도구인 Memento는 매우 다양한 로깅 정보를 수집할 수 있고, 로깅 정보의 특성을 바탕으로, 또는 요청된 설명 수준에 따라 여러 수준에서 고도의 필터링 능력을 제공합니다.

2023.01.18 -

SENTECH SWIR 카메라 이미지 취득 예제

SENTECH SWIR 카메라 이미지 취득 예제1. SWIR Camera 이미지 취득 예 가시광 , SWIR 영역에서의 이미지 비교 (투과로 촬영) 치간 브러쉬 (내부 와이어 확인) , 치석 제거기 (내부의 뾰족한 심부분)의 투과 (850~1,650nm) 치간 브러쉬 (내부 와이어 확인) 폴리에틸렌 내부의 와이어가 제대로 꽂혀있는지 확인이 가능함. 폴리에틸렌은 투과가능한 소재라고 추정됨 . 치석 제거기 (내부의 뾰족한 심부분) 투과되지 않아 내부의 칼날 부분이 확인되지 않음. 치석제거기는 투과되지 않는 소재가 사용 되었다고 추정됨. 반창고 (940~1,650nm) 종이패키지의 문자가 사라져 패키지 내부의 반창고가 확인 가능함. 얇은 종이의 경우 투과 가능, 문자도 색에 따라서는 투과가능하다고 추정됨. 컨넥터 (940~1,650nm) 컨넥터를 투과하여 백색 플라스틱 내부의 선이 누락된 부분을 확인함. 파장을 올릴수록 누락된 부분이 확실하게 보임. 쌀과 이물 검사 (940 ~ 1,650nm) 쌀은 검정색으로 다른 이물질은 (플라스틱, 고무 등) 은 하얗게 보이는 것을 확인함. 쌀은 빛의 흡수율이 높다고 추측됨. 플라스틱 케이스 , 플라스틱 패키지의 투과 (1,200 ~ 1,650nm) 플라스틱 케이스 플라스틱 케이스를 투과하여 내용물이 확인 됨. 비닐 (플라스틱) 봉지 1,2 비닐(플라스틱) 봉지를 투과하여 내용물이 확인됨. IC 카드의 내부 투과 (1,200 ~ 1,650nm) IC 카드 1, IC카드 2 IC카드가 투과되어 내부의 회로가 확인 됨. IC 카드 3 IC 카드 1,2와 비교했을 때 내부가 확인하기 어려웠음. 플라스틱 소재 및 코팅에 의한 IC 카드 내부의 회로는 투과하기 어려운 경우가 있다고 추정됨. 염화비닐 판 (미러) 투과 염화비닐 판 (미러)는 투과되지 않음. 미러는 반사하기 때문에 투과되지 않는 것으로 추정됨. 2. 가시광 , SWIR에서 취득영상을 비교 (반사로 촬영) Pattern wafer , Film wafer , Bare wafer 의 투과 (1,200 ~ 1,550nm) Pattern wafer 1,200 ~ 1,550nm 에서 표면의 패턴, 웨이퍼 안쪽에 설치된 차트를 확인함. Film Wafer Film wafer , Bare wafer 모두 안쪽에 설치된 차트를 투과하지 못함. Film wafer , Bare wafer는 Pattern wafer의 코팅 차이에 의해 투과하지 못한 것으로 추정됨 플라스틱 패키지 , 알루미늄 패키지 내부의 투과 (1,200 ~ 1,650nm) 플라스틱 패키지 3 외장을 투과하여 내용물 , 조미료가 들어있는 것을 확인함. 외장의 일러스트레이션 및 문자의 일부가 투과되지 않는 사실로부터 인쇄소재에 의해 투과하지 않는 경우가 있다고 추정됨. 알루미늄 패키지 외장이 투과되지 않아 내용물 확인이 불가능함. 봉지 안쪽에 코팅이 되어있어 반사되어 투과되지 않았다고 추정됨. 소금과 설탕 비교 (1,200 ~ 1,650nm) 소금은 하얗게, 설탕은 검게 보이는 것을 확인함. 설탕은 소금에 비해 빛 흡수력이 더 높다고 추정됨. 방향제 (백색의 탁한 액체)의 내용 확인 (870~1,050nm) 870nm 파장에서 액체 내부의 여과지를 확인함. 백색의 탁한 액체도 물과 같은 레벨의 빛을 흡수하는 것으로 보이며 1,200nm 이상이되자 검게 보임. 라벨제거제(액체), 오일, 물 비교 (1,200~1,650nm) 물은 1,200nm 이후 부터 검게 보이는 반면 오일과 라벨제거제는 투과됨. 라벨제거제 및 오일에 포함된 성분에는 빛을 흡수하는 정도가 낮다고 추정됨. 액체 풀, 간장 , 물 비교 (870~1,650nm) 870~1,000nm에서 간장은 투과되어 1,200nm 이후에는 검게 보임) 물과 액체 풀도 강장과 같이 1,200nm이후에는 검게 보임. 물과 액체 풀의 성분, 콩은 1,200nm이후 빛의 흡수율이 비슷해진다고 추정됨. 백색 스폰지에 부착된 수분 검출 (1,200 ~ 1,550nm) 수분을 흡수하고 있지 않는 부분은 흰색으로, 수분을 흡수하고 있는 부분은 검은색으로 보임. 1,450nm 부근에서 물이 검은색으로 보여 안쪽까지 수분 검출이 가능했음. Liquid Leakage(백색 뚜껑, 검은색 뚜껑) 비교 (1,200 ~ 1,550nm) 백색 뚜껑 백색 뚜껑에 부착된 물방울을 확인함. 1,200nm 이상의 경우 물이 검은색으로 보이는 것을 확인함. 검은색 뚜껑 1,200nm 이상의 경우 물이 검은색으로 보이기 때문에 뚜껑의 경우 Liquid leakage 검출이 어려움. 검은색 이외의 뚜껑의 경우 판별 가능할 것으로 추정됨. 사과의 상한 부분 검출 (1,200~1,550nm) 상한 부분이 컬러 이미지와 비교해 강조되어 보이는 것을 확인. 상한 부분에 수분이 모이기 때문에 1,450nm 부근에서 검은색으로 보이는 것으로 추정됨. 양배추 수분 검출(1,200 ~ 1,550nm) 양배추의 수분이 많은 부분이 1,200nm 이상의 파장대에서 확인됨. 3. 가시광 , SWIR 취득 이미지 비교 (IR조명 미사용) 인두의 열감지 가시광 영역의 카메라에서는 인두 선단이 하얗게 보이지 않음. SWIR 카메라에서는 인두의 선단이 하얗게 보임을 확인함(약 250ºC 이상의 적외선 검출) 안개 투과 가시광보다 파장이 길기 때문에 대기중의 미립자의 영향을 덜 받아 안개속의 대상물이 비교적 잘보임.

2022.11.09 -

JAI, 새로운 8.1 메가픽셀 UV 카메라 출시

JAI, 새로운 8.1 메가픽셀 UV 카메라 출시JAI가 고성능 5GBASE-T(5GigE) 인터페이스를 탑재한 새로운 8.1 메가픽셀 UV 고감도 카메라,Go 시리즈 GO-8105M-5GE-UV 모델을 출시했습니다. 향상된 해상도(8.1 메가픽셀 vs. 5 메가픽셀)와 UVA, UVB를 넘어 UVC까지 확장된 더 높은 스펙트럼 감도를 제공하는 이 새로운 카메라는 JAI의 다른 3가지 UV(자외선) 카메라 모델보다 뛰어난 성능을 제공합니다. Sony Pregius S IMX487-AAMJ CMOS 센서를 29 x 29 x 68mm의 소형 폼팩터에 탑재한 GO-8105M-5GE 모델은 5GigE 인터페이스를 통해 초당 최대 66 프레임의 풀 해상도 8.1 메가픽셀 이미지를 생성합니다. 카메라 인터페이스에는 사용 가능한 대역폭에 따라 네트워크 성능 및 호스트 PC에 맞춰 카메라의 출력을 2.5GBASE-T(2.5Gbps) 또 1000BASE-T(1Gbps)로 자동으로 조정해주는 기능(자동 협상 기능)이 탑재되어 있습니다. 카메라는 Pregius S 센서의 2.74µm 픽셀 크기를 통해 컴팩트한 2/3” C-마운트 광학 형식을 제공합니다. Pregius S 센서에는 이미징 성능의 저하 없이 작은 픽셀 크기를 지원하는 후면 조명이 탑재되어 있습니다. 8 bit, 10 bit 및 12 bit 출력 형식도 지원가능 합니다. GO-8105M-5GE-UV 모델은 2가지 구성으로 제공됩니다. 표준 모델은 센서 위에 장착된 이중 AR 코팅된 석영 유리 커버를 통해 센서를 먼지와 손상으로부터 보호하는 동시에 광 투과율을 극대화합니다. 글래스리스(glassless) 모델(GO-8105M-5GE-UV-GL)은 센서 위에 보호 유리 커버가 장착되어 배송되며 커버 유리를 통과하는 빛의 간섭이 허용되지 않는 애플리케이션의 경우 사용자가 이를 제거할 수 있습니다. 새로운 카메라의 해상도, 프레임 속도 및 자외선 감도는 반도체 마스크 검사, 웨이퍼 처리, 폐기물 분류, 형광 분석, 고전압 기술, 현미경 검사, 피부과 등 다양한 애플리케이션에 적합합니다. 이러한 애플리케이션을 지원하기 위해 내장된 카메라 기능에는 수평/수직 이미지 반전 기능, 불량화소 보정, 음영 보정, 시퀀서 기능, 다중 비닝/크기 조정 모드 및 변화하는 조명 조건에서 노출을 제어하기 위한 자동 셔터 및 자동 게인 기능을 연결하는 자동 레벨 제어(ALC) 기능 등이 포함되어 있습니다. GO-8105M-5GE-UV 모델은 JAI가 제공하는 Go 시리즈 소형 산업용 카메라의 25번째 모델입니다. 다른 모델에는 2.35 또는 5 메가픽셀의 해상도 및 GigE Vision, USB3 Vision 또는 Camera Link 인터페이스가 탑재된 흑백 및 컬러 머신 비전 카메라, 편광 이미징 애플리케이션을 지원하는 온센서 편광 그리드가 장착된 2가지 모델 등이 있습니다. 화인스텍은 머신비전 솔루션 그 이상을 만듭니다. (www.fainstec.com)

2022.11.03 -

3D 스캐너 / 소프트웨어 조합으로 캔음료 검사하기

3D 스캐너 / 소프트웨어 조합으로 캔음료 검사하기그림 1: AT 3D센서는 캔 뚜껑의 곡률을 스캔하고 3D 포인트 클라우드 데이터를 생성합니다. (사진제공 AT - Automation Technology) 한 글로벌 음료 제조업체는 음료 충전 및 뚜껑 밀봉 과정에서 발생하는 캔 뚜껑의 곡률 결함으로 인한 공정 중 가동 정지 시간을 줄이고 품질 관리 개선을 위해 캔 압력 검사가 필요했습니다. 이러한 가동 중지 시간을 없애고 공정을 최적화하여 생산량을 늘리기 위해 제조업체는 캔 압력을 검사하는 어플리케이션을 개발하려고 했습니다. 하지만 문제는 3D 스캐너를 사용하여 컨베이어 벨트에서 최대 속도로 이동하고 있는 캔의 압력을 바로 검사하는 것이었습니다. AT – Automation Technology(독일 Bad Oldesloe, www.automationtechnology.de) 및 EVT – Eye Vision Technology (독일 Karlsruhe, www.evt-web.com)는 이와 같은 어플리케이션에 대한 3D 솔루션을 제공해 드리고 있습니다. 과정 소비자가 음료가 들어 있는 캔을 열면 음료가 탄산이든 아니든 간에 쉬익 소리가 납니다. 그 쉬익 소리는 그냥 나는 것이 아닙니다. 이 소리를 통해 캔이 적정한 충전량과 충전 압력으로 채워져 있는지를 확인 할 수 있습니다. 충전 기계는 이 과정을 매일 수천 번 수행합니다. 소비자가 캔을 열 때 쉬익 하는 소리가 들리지 않으면 무언가 이상하다고 생각 할 수 있습니다. 그렇기 때문에 적정한 충전량과 충전 압력을 유지 하는 것은 매우 중요 합니다. AT와 EVT는 캔음료를 검사하는 어플리케이션을 만들었습니다. 24시간 작동하며 초당 40개의 캔(분당 2,400캔), 하루 350만개의 캔을 스캔 할 수 있습니다. AT/EVT 솔루션을 적용하기 전에 음료 제조업체는 one-point 센서(한 점의 높이를 측정)를 사용하여 캔을 검사했지만 원하는 결과를 얻지 못했습니다. One-point 센서가 너무 부정확하여 결국 너무 많은 불량품이 발생했습니다. 당시 EVT는 이미 라벨 위치 검사, 캔의 목 검사 또는 스크래치 검사와 같은 2D 검사를 이 공장에 공급 중인 업체였습니다. 제조업체는 EVT가 3D 솔루션도 제공한다는 사실을 듣고 캔 압력 검사용 어플리케이션을 개발하게 되었습니다. 해결책 이 어플리케이션을 위해서 AT사의 C5-CS 3D센서와 EVT사의 소프트웨어를 사용 하였으며 소프트웨어는 현장의 검사 시스템에 연결된 리눅스 컴퓨터에 설치 되었습니다. 데이터는 GigE 인터페이스를 통해 전송됩니다. 제조업체는 압력을 제어하기 위해서 캔을 운반하는 컨베이어 벨트에 트래커를 장착했습니다. 이 트래커는 캔의 위치를 실시간으로 추적하며 AT의 3D센서인 C5-2040CS23-100에 신호를 전달합니다. AT 3D센서는 캔 상단 면의 높이, 형상을 스캔하여 3D 포인트 클라우드 데이터를 생성합니다. 그런 다음 EVT 소프트웨어는 이 포인트 클라우드 데이터를 사용하여 높이, 형상 값을 확인하고 캔의 압력이 높은지, 낮은지를 검사합니다. 그렇게 3D 포인트 클라우드 데이터를 이용한 캔의 압력 검사 시스템이 완성 되었습니다. 그림 2: EVT 소프트웨어는 포인트 클라우드 데이터를 이용하여 곡률을 확인하고 캔에 과압 또는 저압이 있는지 검사합니다. 먼저 항상 같은 위치에 있는 캔의 테두리를 기준으로 잡고 캔 상단에서 가장 높은 위치에 있는 캔마개의 위치를 가지고 캔 상단 면의 불룩함 정도를 측정 합니다. 캔에는 최소 150μ의 압력이 있어야 하며 100μ 미만이면 압력이 너무 낮으므로 캔을 불량으로 처리해야 합니다. 이 측정에는 허용 오차가 있으며 캔 곡률 값이 이 허용 오차를 벗어나는 즉시 컨베이어 벨트 측면에 부착된 노즐에서 압축 공기로 캔이 배출됩니다. 위 검사가 정상적으로 동작하는지 확인하기 위해 하루에 한 캔은 표면 마감 불량으로 인한 불량 처리가 되는지 확인합니다. AT는 프로파일 당 2,048포인트의 해상도와 초당 25,000 프로파일의 속도 때문에 이 어플리케이션에 C5-2040CS-23-100을 사용하기로 결정했습니다. 센서는 100mm의 X축 FOV를 가지고 있어 센서가 컨베이어 벨트의 캔 위치 변화에도 유연하게 반응할 수 있습니다. 그리고 이 센서는 GenICam 호환 카메라이기 때문에 소프트웨어는 GenICam을 통해 카메라를 제어하고 포인트 클라우드 데이터를 획득한 다음 소프트웨어가 이 포인트 클라우드 데이터를 처리 및 검사합니다. EVT 소프트웨어는 3D 검사 도구가 있는 EYE Vision Standard 소프트웨어로 구성됩니다. 이 어플리케이션에서는 조명 설치 공간 확보부터 시작하여 여러 가지 조명에 관련된 문제를 생각할 필요가 없었습니다. 그 이유는 AT 3D 센서는 카메라와 레이저가 일체형이며 컴팩트 하기 때문 입니다. 그리고 레이저 광을 사용한 프로파일 측정은 매우 견고하며 주변 빛의 간섭이 없기 때문 입니다.

2022.10.31 -

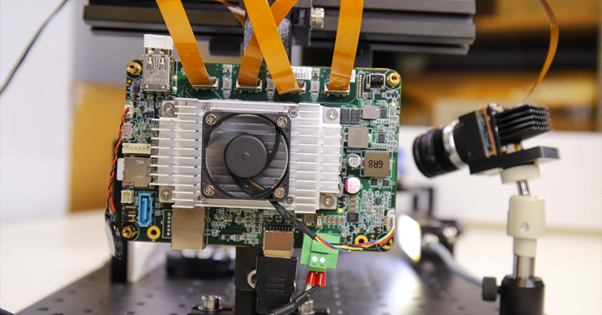

소형 캐리어 보드로 4대의 카메라 스트리밍 하기

소형 캐리어 보드로 4대의 카메라 스트리밍 하기임베디드 비전 구성품은 수많은 어플리케이션에 통합되고 있습니다. 이러한 모든 어플리케이션의 공통점은 더 많은 기능을 컴팩트하게 통합해야 한다는 것입니다. Teledyne FLIR는 이러한 시스템을 신속하게 프로토타입화 할 수 있는 TX2용 Quartet™ Embedded 솔루션을 도입했습니다. 이 커스텀 캐리어 보드를 사용하면 전체 대역폭에서 최대 4대의 USB3 머신 비전 카메라를 쉽게 통합할 수 있습니다. 이 보드는 NVidia Jetson 딥러닝 하드웨어 가속기가 포함되어 있으며, Teledyne FLIR의 Spinnaker® SDK가 사전 설치되어 있습니다. 검사, 모바일 로봇, 교통 시스템 및 다양한 유형의 무인 차량과 같은 시스템을 현장에서 구현하는 것은 큰 장점이 될 수 있습니다. 그림 1: 4가지 어플리케이션에 적용된 프로토타입 이 글에서는 Quartet 보드로 무엇을 할 수 있는지 강조하기 위해 동시에 4개의 어플리케이션을 실행하는 ITS(교통 시스템)를 개발하는 단계를 소개해드리겠습니다. 그 중 3개는 딥 러닝을 사용합니다. 어플리케이션1: 딥 러닝을 이용한 번호판 인식 어플리케이션2: 딥 러닝을 이용한 차량 유형 분류 어플리케이션3: 딥 러닝을 이용한 차량 색상 분류 어플리케이션4: 앞 유리창 투과(빛 반사 상황) 구매 목록: 하드웨어 및 소프트웨어 구성품 1. 프로세싱을 위한 SOM(System on Module) TX2용 Teledyne FLIR Quartet 캐리어 보드에는 다음과 같이 구성되어있습니다. - 전용 USB3 컨트롤러가 있는 TF38 커넥터 4개 - Nvidia Jetson TX2 모듈 -Teledyne FLIR의 강력하고 사용하기 쉬운 Spinnaker SDK가 사전 설치되어 Teledyne FLIR Blackfly S 보드 레벨 카메라와의 플러그 앤 플레이 호환성 보장 - Nvidia Jetson 딥 러닝 하드웨어 가속기는 단일 컴팩트 보드에서 완전한 의사 결정 시스템을 가능하게 함 그림 2: Blackfly S board level, FPC cable, TX2가 포함된 Quartet 임베디드 솔루션 2. 카메라 및 케이블 - Teledyne FLIR Blackfly S USB3 보드 레벨 카메라 3대: 최신 CMOS 센서가 적용되어 있고, 케이스 버전과 동일하게 풍부한 기능을 지원하며 Quartet과의 호환성이 높음 - 커스텀 카메라 1대: Sony IMX250MZR 편광 센서가 탑재된 Blackfly S USB3 보드 레벨 카메라 - 케이블: TF38 FPC 케이블로 전력 및 데이터를 단일 케이블로 전송하여 공간 절약 그림 3: FPC 케이블이 연결된 Blackfly S 보드 레벨 카메라 3. 조명 : 번호판의 모션 블러를 방지하기 위해 충분한 광량을 제공하는 LED 조명 3.1 - 어플리케이션1 딥 러닝을 이용한 번호판 인식 개발 시간: 견고하고 빠른 실행을 위해 2-3주 소요 학습 이미지: LPDNet 사용 번호판 인식을 위해 Nvidia의 기성품인 LPDNet(License Plate Detection) 딥 러닝 모델을 사용하여 번호판의 위치를 ??감지했습니다. 그리고 문자와 숫자를 인식하기 위해 Tesseract 오픈 소스 OCR 엔진을 사용 했고 카메라는 Sony IMX267 센서가 탑재된 Blackfly S 보드 레벨 8.9MP 컬러 카메라(BFS-U3-88S6C-BD)를 사용 중입니다. 성능 및 속도를 높이기 위해 번호판 감지에 대한 관심 영역(ROI)을 제한하고, 견고성을 향상시키기 위해 추적(Tracking)을 적용했습니다. 해당 번호판의 문자와 번호판에 바운딩 박스가 표시됩니다.. 그림 4: 번호판의 문자 및 번호판에 바운딩 박스가 표시되는 영상 3.2 - 어플리케이션2 딥 러닝을 이용한 차량 유형 분류 개발 시간: 이미지 수집 및 어노테이션(Annotation)을 포함하여 최대 12시간 학습 이미지: ~300 차량 유형 분류를 위해 전이 학습(Transfer learning)을 사용하여 SUV, 세단 및 트럭과 같은 세 가지 장난감 자동차에 대해 자체 딥 러닝 객체 감지 모델을 학습했습니다. 다양한 거리와 각도에서 촬영한 약 300개의 트레이닝 이미지를 수집했고 카메라는 Sony IMX250 센서가 탑재된 Blackfly S 보드 레벨 5MP 컬러 카메라(BFS-U3-51S5C-BD2)를 사용 중 입니다. 장난감 자동차의 바운딩 박스에 어노테이션을 추가하는데 약 3시간이 소요됐습니다. 자체 SSD MobileNet 객체 감지 모델을 트레이닝하기 위해 전이 학습을 수행했으며, Nvidia GTX1080 Ti GPU에서 반나절 정도 소요됐습니다. GPU 하드웨어 가속기를 통해 Jetson TX2 모듈은 딥 러닝 추론을 효율적으로 수행하고 해당 차량 유형과 함께 자동차에 바운딩 박스를 출력할 수 있습니다. 그림 5: 바운딩 박스와 사전 설정된 차량 유형, 식별된 신뢰도 점수가 표시되는 영상 3.3 - 어플리케이션3 딥 러닝을 이용한 색상 분류 개발 시간: 색상 분류, 통합 및 테스트를 위해 ‘차량 유형 어플리케이션’ 모델을 재사용하여 2일 추가 소요 학습 이미지: ‘차량 유형 어플리케이션’과 동일한 300개 이미지 재사용 차량 색상 분류를 위해 위와 동일한 딥 러닝 객체 감지 모델을 실행하여 차량을 감지하고, 바운딩 박스에 대한 이미지 분석을 통해 색상을 분류했습니다. 해당 차량 색상과 함께 자동차에 바운딩 박스가 표시됩니다. 카메라는 Sony IMX252 센서가 탑재된 Blackfly S 보드 레벨 3MP 컬러 카메라(BFS-U3-32S4C-BD2)를 사용 중 입니다. 그림 6: 바운딩 박스 및 미리 설정된 색상 유형이 식별된 영상 3.4 - 어플리케이션4 앞 유리창 투과(빛 반사 상황) 앞 유리를 통해 HOV차선을 모니터링하고 안전 벨트 착용 여부를 확인하고 심지어 운전 중 휴대폰 사용 여부까지 확인하는 등 교통 관련 어플리케이션에 빛 반사 제거 기능은 매우 중요합니다. 이를 위해 Blackfly S USB3 보드 레벨 카메라와 5MP Sony IMX250MZR 편광 센서를 결합하여 커스텀 카메라를 만들었습니다. 이 보드 레벨 편광 카메라는 표준 제품이 아니지만, Teledyne FLIR에서는 다양한 센서를 쉽게 교체하여 커스텀 카메라 옵션 제공이 가능하여 빛 반사 제거 기능을 보여주는 커스텀 카메라 옵션을 제공하였습니다. 고정된 장난감 자동차의 빛 반사 감소를 보여주기 위해 쿼드 모드(Quad mode), 빛 반사 감소 모드와 같은 다양한 "편광 알고리즘" 옵션을 제공하는 Teledyne FLIR의 SpinView GUI를 통해 카메라 이미지를 간단히 스트리밍했습니다. 그림 7: Spinnaker SDK는 쿼드 모드, 빛 반사 감소 모드와 같은 다양한 “편광 알고리즘” 옵션을 제공하여 고정된 장난감 자동차의 빛 반사 감소를 보여줍니다. 쿼드 모드는 4개의 서로 다른 편광 각도에 해당하는 이미지를 보여줍니다. 전반적인 시스템 최적화 4개의 각 프로토타입은 독립적으로는 잘 작동하지만, 모든 딥 러닝 모델이 동시에 실행될 때 전반적인 성능이 상당히 좋지 않다는 것을 알았습니다. Nvidia의 TensorRT SDK는 Jetson TX2 모듈과 같은 Nvidia 하드웨어용 딥 러닝 추론 옵티마이저(Inference optimizer) 및 런타임을 제공합니다. 이 TensorRT SDK를 사용하여 딥 러닝 모델을 최적화하여 성능이 약 10배 향상되었습니다. 그리고 모든 어플리케이션이 실행 중일 때 발열이 심해 TX2 모듈에 방열판을 부착했습니다. 결과적으로 차량 유형 식별에서 14fps, 차량 색상 분류에서 9fps, 자동 번호판 인식에서 4fps 그리고 편광 카메라에서 8fps까지 4가지 어플리케이션을 모두 실행할 때 좋은 프레임 속도를 달성했습니다. Quartet Embedded Solution 및 Blackfly S 보드 레벨 카메라의 사용 용이성과 신뢰성 덕분에 비교적 짧은 시간 내에 프로토타입 개발을 완료하였습니다. Spinnaker SDK가 사전 설치된 TX2 모듈은 TF38 연결을 통해 전체 USB3 대역폭에서 안정적으로 스트리밍할 수 있는 모든 Blackfly S 보드 레벨 카메라와의 플러그 앤 플레이 호환성을 보장합니다. Nvidia는 TX2 모듈에서 개발 및 최적화를 용이하게 하는 많은 툴을 제공합니다. Quartet은 이제 flir.com은 물론 flir.com 사무실과 글로벌 대리점들을 통해 구매하실 수 있습니다. 제품 링크 : Blackfly S 보드 레벨 카메라 : http://www.fainstec.com/main/search.asp?schStr=BD2 Blackfly S 편광 카메라 케이스 버전 : http://www.fainstec.com/main/search.asp?schStr=51S5P-C Quartet보드: http://www.fainstec.com/main/search.asp?cate=%EB%B3%B4%EB%93%9C&o_idx=125&schStr=Quartet

2022.09.16 -

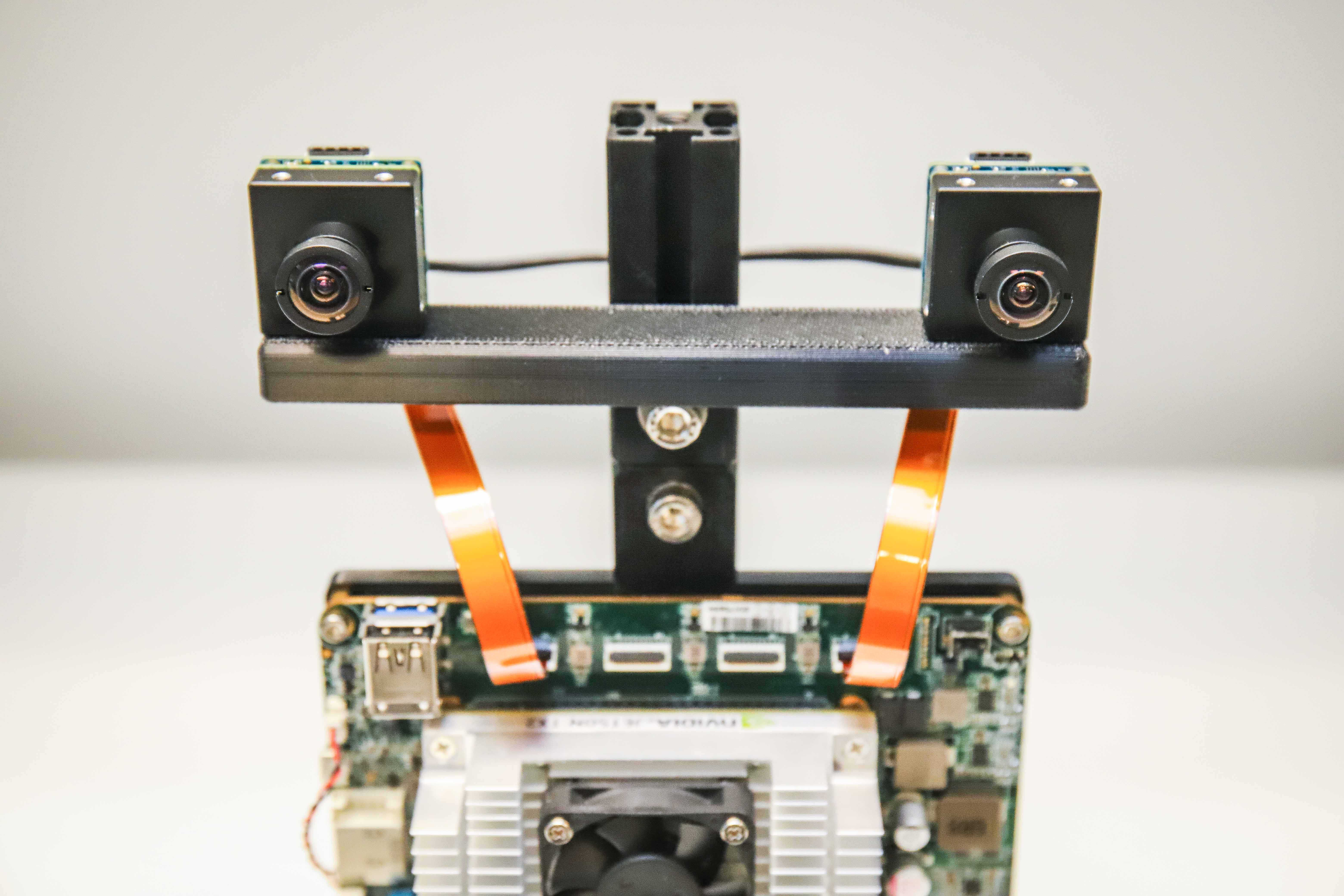

깊이 측정을 위한 커스텀 임베디드 스테레오 시스템

깊이 측정을 위한 커스텀 임베디드 스테레오 시스템깊이 측정을 위한 커스텀 임베디드 스테레오 시스템 깊이 측정 시스템 개발을 위한 3D 센서 옵션에는 다양한 옵션들이 있는데요, 카메라가 있는 스테레오 비전, 라이다 및 TOF센서가 대표적입니다. 그리고 각 옵션에는 장단점이 있습니다. 그중 스테레오 비전 시스템은 일반적으로 비용이 저렴하고 실외에서 사용하기에도 충분히 견고하며 고해상도 컬러 포인트 클라우드를 제공합니다. 오늘날 시장에서 사용할 수 있는 다양한 기성 스테레오 시스템이 존재하지만, 정확도, FOV, 해상도 등과 같은 요인에 따라 시스템 엔지니어가 특정 어플리케이션 분야의 요구 사항을 해결하기 위해 커스텀 시스템을 구축해야 하는 경우도 있습니다. 먼저 스테레오 비전 시스템의 주요 파트를 설명한 다음 기성 하드웨어 부품 및 오픈소스 소프트웨어를 사용하여 커스텀 스테레오 카메라를 만드는 방법에 대해 설명 하도록 하겠습니다. 커스텀 시스템의 구성은 임베디드에 초점을 맞추기 때문에 호스트 PC 없이도 실시간으로 모든 장면의 Depth Map을 계산할 수 있습니다. 스테레오 비전 개요 스테레오 비전은 두개의 다른 시점에서 촬영한 두 이미지의 정보를 비교하여 디지털 이미지에서 3D 정보를 추출하는 것입니다. 두 이미지 평면에서 물체의 상대적 위치는 카메라에서 물체까지의 거리 즉 깊이에 대한 정보를 제공해줍니다. Figure 1 – 스테레오 비전 시스템 개요 스테레오 비전 시스템의 개요는 위 이미지와 같으며 다음과 같은 주요 단계로 구성됩니다. 1. 캘리브레이션 – 카메라 캘리브레이션의 경우 두가지 의미가 있습니다. Instrinsic(내부적인) 캘리브레이션의 경우는 이미지 중심, 초점 거리 및 왜곡 파라미터를 말하며, Extrinsic(외부적인) 캘리브레이션은 카메라의 실제 위치 등을 말합니다. 컴퓨터 비전 프로그램에서 특히 깊이와 같은 이미지의 메트릭 정보가 필요한 경우 캘리브레이션 단계는 매우 중요합니다. 캘리브레이션 단계에 대해서는 아래 캘리브레이션 섹션에서 자세히 설명 드리겠습니다. 2. 렉티피케이션 – 스테레오 렉티피케이션은 이미지 평면을 양쪽 카메라의 중심 사이의 선과 평행한 공통 평면으로 조정하는 프로세스를 말합니다. 렉티피케이션 이후 해당 포인트가 평행하게 놓여 있게 되므로 매칭에 소요되는 시간이 줄어들기 때문에 꼭 필요한 과정으로 인식되고 있습니다. 이 단계는 커스텀 시스템을 구축하기 위해 제공된 코드로 실행 가능합니다. Figure 2 – Stereo Rectification 예시 3. 스테레오 매칭 – 왼쪽과 오른쪽 이미지 사이에 픽셀을 일치시켜주는 과정을 스테레오 매칭이라고 하며, Disparity image(불균형한 이미지)를 생성하게 됩니다. SGM(Semi-Global Matching) 알고리즘은 커스텀 시스템을 구축하기 위해 제공되는 코드에 사용됩니다. 4. Triangulation(삼각측량) – 삼각 측량은 두 이미지에 투영 된 3D 공간의 점을 결정하는 과정을 말합니다. Disparity image(불균형한 이미지)는 3D 포인트 클라우드로 변환됩니다. 설계 예제 스테레오 시스템의 설계 예제를 살펴보겠습니다. 다음은 빠르게 움직이는 물체가 있는 동적 환경인 모바일 로봇 어플리케이션에 대한 요구 사항입니다. ROI 크기는 2m, 카메라에서 목표물까지의 거리는 3m, 원하는 정확도는 1cm입니다. 깊이 오차는 다음과 같은 요인에 따라 ΔZ=Z²/Bf * Δd에 의해 주어집니다: Z = 범위 B = Baseline(기준선) F = focal length(픽셀 단위의 초점 거리로, 카메라 시야 각 및 이미지 해상도와 관련 있습니다) 처음에 언급한 요구 사항을 충족할 수 있는 다양한 설계 옵션들이 있는데, 원하는 FOV와 WD에 따라 특정 센서에 대한 렌즈의 초점 거리를 정할 수 있습니다. Baseline(기준선)으로 위의 공식을 사용하여 3m에서 예상 깊이 오차를 계산하여 요구되는 정확도를 충족하는지 확인할 수 있습니다. Figure 3 – 예제 어플리케이션에 대한 스테레오 시스템 설계 옵션 위 이미지는 Baseline(기준선)이 긴 저해상도 카메라 또는 Baseline이 짧은 고해상도 카메라 이렇게 두가지 옵션에 대한 설명입니다. 첫번째 옵션은 전체적으로 크기가 더 큰 카메라이지만 복잡한 계산의 필요성이 적고 두번째의 경우는 크기는 더 컴팩트 하지만 복잡한 계산의 필요성이 높습니다. 예제 어플리케이션에서는 컴팩트 한 크기가 모바일 로봇 어플리케이션에 더 적합하기 때문에 두번째 옵션을 선택했으며, 요구되는 프로세스를 처리 할 수 있는 강력한 GPU가 탑재된 TX2 용 Quartet Embedded Solution을 사용할 수 있습니다. 하드웨어 요구 사항 Figure 4 – 커스텀 임베디드 스테레오 시스템의 앞면과 뒷면 이 예에서는 IMX273 Sony Pregius 글로벌 셔터 센서를 사용하여 두 대의 Blackfly S 1.6MP 보드 레벨 카메라를 12cm Baseline(기준선)를 가진 3D 프린트된 프레임에 장착합니다. 두 카메라 모두 동일한 6mm S-마운트 렌즈를 장착했습니다. 카메라는 FPC 케이블을 사용하여 TX2 커스텀 캐리어 보드용 Quartet Embedded Solution에 연결됩니다. 왼쪽과 오른쪽 카메라를 동기화하여 동시에 이미지를 캡처하기 위해 두 카메라를 연결하는 동기화 케이블도 연결합니다. 위 이미지의 하드웨어 구성품은 다음과 같습니다 : Quartet Carrier with TX2 Module 8GB – 1ea BFS-U3-16S2C-BD2(카메라) – 2ea S-Mount & IR filter – 2ea 6mm S-Mount lens(렌즈) – 2ea 15cm FPC 케이블 – 2ea NVIDIA Jetson TX2/TX2 4GB/TX2i Active Heat Sink(방열판) – 1ea 동기화 케이블 – 1ea 카메라 부착용 프레임 – 1ea 두 렌즈 모두 어플리케이션이 요구하는 범위에 카메라 초점이 맞도록 조정해야 합니다. 초점을 맞춘 후 초점을 고정하기 위해 각 렌즈의 나사를 조여줍니다. (Figure 5 참고) Figure 5 – 렌즈 나사를 보여주는 스테레오 시스템의 측면도 소프트웨어 요구 사항 a. Spinnaker Teledyne FLIR Spinnaker SDK는 TX2용 Quartet Embedded Solution에 사전 설치되어 제공됩니다. 카메라와 통신하기 위해선 Spinnaker가 필요합니다. b. CUDA를 지원하는 OpenCV 4.5.2 스테레오 매칭 알고리즘 중 하나인 SGM을 사용하기 위해선 OpenCV 4.5.1 버전 또는 그 이상의 버전이 필요합니다. 코드를 포함하고 있는 첨부된 zip 파일을 다운로드 후 압축을 풀어줍니다. 리눅스 터미널에서 아래와 같이 OpenCV를 설치하는 스크립트 인 OpenCVInstaller.sh를 실행합니다. cd ~/StereoDepth chmod +x OpenCVInstaller.sh ./OpenCVInstaller.sh 설치 관리자를 통해 관리자 암호를 설정 후 OpenCV 4.5.2 설치가 시작됩니다. OpenCV를 다운로드하고 빌드하는데 몇 시간이 걸릴 수도 있습니다. 캘리브레이션 스테레오 이미지를 불러와 캘리브레이션 하는 코드는 “Calibration” 폴더에서 확인할 수 있습니다. SpinView GUI를 사용하여 좌우 카메라의 일련 번호를 확인합니다. 우측 카메라는 마스터, 좌측 카메라는 슬레이브로 설정해 줍니다. 마스터 및 슬레이브 카메라의 일련 번호를 grabStereoImage.cpp 파일의 60번째와 61번째 줄에 복사해줍니다. 리눅스 터미널에서 다음 명령어를 사용하여 실행 파일을 빌드합니다. cd ~/StereoDepth/Calibration mkdir build mkdir -p images/{left, right} cd build cmake .. make 첨부된 채커보드 패턴을 인쇄하여 평평한 표면에 부착 후 캘리브레이션 타켓으로 사용할 수 있습니다. 캘리브레이션을 하는 동안 최상의 결과를 얻으려면 SpinView에서 Exposure Auto는 off로 설정하고 아래 그림과 같이 채커보드 패던이 선명하고 흰색 부분이 과하게 노출되지 않도록 노출을 조정해줍니다. 캘리브레이션 이미지가 수집된 후 SpinView에서 게인 및 노출을 자동으로 설정할 수 있습니다. Figure 6 – SpinView GUI 설정 이미지 수집을 시작하기 위해 아래 명령어를 입력해줍니다. ./grabStereoImages 코드에 따르면 이미지 수집은 약 초당 1프레임의 속도로 진행됩니다. 왼쪽의 이미지는 images/left 폴더에 저장되고 오른쪽의 이미지는 images/right 폴더에 저장됩니다. 타겟을 움직여 이미지의 구석 부분까지도 잘 보이게 촬영해줍니다. 타겟을 회전 시켜 가까이서, 그리고 또 멀리서도 찍어줍니다. 기본적으로 프로그램은 100쌍의 이미지를 캡처하지만 아래 명령어를 사용하여 변경도 가능합니다. ./grabStereoImages 20 위의 명령어를 사용하면 20쌍의 이미지만 수집됩니다. 이전 폴더에 저장된 모든 이미지를 덮어 쓰는 점은 참고하셔야 됩니다. 아래 이미지는 일부 캘리브레이션 이미지 샘플입니다. Figure 7 – 샘플 캘리브레이션 이미지 이미지 수집 후 다음 명령어를 통해 캘리브레이션 Pyhton 코드를 실행합니다. cd ~/StereoDepth/Calibration python cameraCalibration.py 위 명령어로 스테레오 시스템의 내부 및 외부 파라미터가 포함된 "intrinsics.yml"및 "extrinsics.yml"이라는 2개의 파일이 생성됩니다. 기본적으로 30mm 정사각형 크기의 채커보드를 가정하여 만든 코드이지만 필요한 경우 편집이 가능합니다. 캘리브레이션이 끝나면 캘리브레이션이 얼마나 잘 수행 되었는지를 나타내는 RMS 오류가 표시됩니다. 캘리브레이션이 잘 된 경우 RMS 오류는 일반적으로 0.5 픽셀 미만입니다. Real-time Depth Map 실시간으로 차이(disparity)를 계산하는 코드는 “Depth” 폴더 내에 있습니다. 카메라의 일련 번호를 복사하여 live_disparity.cpp의 230과 231번째 줄에 붙여 넣습니다. 리눅스 터미널에서 다음 명령어를 사용하여 실행파일을 빌드합니다. cd ~/StereoDepth/Depth mkdir build cd build cmake .. make 캘리브레이션 단계에서 얻은 "intrinsics.yml" 및 "extrinsics.yml" 파일을 이 폴더에 복사합니다. 실시간으로 Depth Map 데모를 실행하려면 다음 명령어를 입력합니다. ./live_disparity 왼쪽 카메라 이미지(Raw 이미지)와 Depth Map(최종 output)이 표시됩니다. 아래 이미지는 몇가지 예제 output을 보여주고 있습니다. 카메라로부터의 거리는 Depth Map의 오른쪽에 표시된 범례에 따라 색상으로 구분됩니다. Depth Map의 검은색 영역은 해당 영역에서 차이(disparity)점이 있는 데이터가 없다는 것을 의미합니다. NVIDIA Jetson TX2 GPU로 1440 x 1080의 해상도에서 최대 초당 5프레임, 720 x 540의 해상도에선 최대 초당 13프레임 속도로 실행할 수 있습니다. 특정 지점의 깊이 데이터는 Depth Map에서 해당 지점을 클릭하여 아래 이미지와 오른쪽 하단 이미지와 같이 깊이가 표시되는 것을 확인할 수 있습니다. Figure 8 – 왼쪽 카메라 이미지 및 해당 Depth Map 샘플 / 하단의 Depth Map에서는 특정 지점의 깊이를 보여줍니다. 요약 스테레오 비전을 사용하여 깊이 측정 시스템을 개발하면 실외에서도 잘 작동이 가능하며, 고해상도 Depth Map을 제공하고, 저렴한 기성품들로 매우 쉽게 접근할 수 있다는 장점이 있습니다. 시장에는 이미 요구 조건이 정해진 기성 스테레오 시스템이 많이 있습니다. 커스텀 임베디드 스테레오 시스템을 개발해야하는 경우 이 글에서 설명 드린 내용처럼 비교적 간단하게 작업하실 수 있습니다.

2022.09.07